Grenzen der Künstlichen Intelligenz Warum die KI so gerne lügt

Sprachmodelle wie Chat-GPT erfinden gerne Dinge und klingen dabei höchst überzeugend. Das lässt sich gar nicht so leicht beheben.

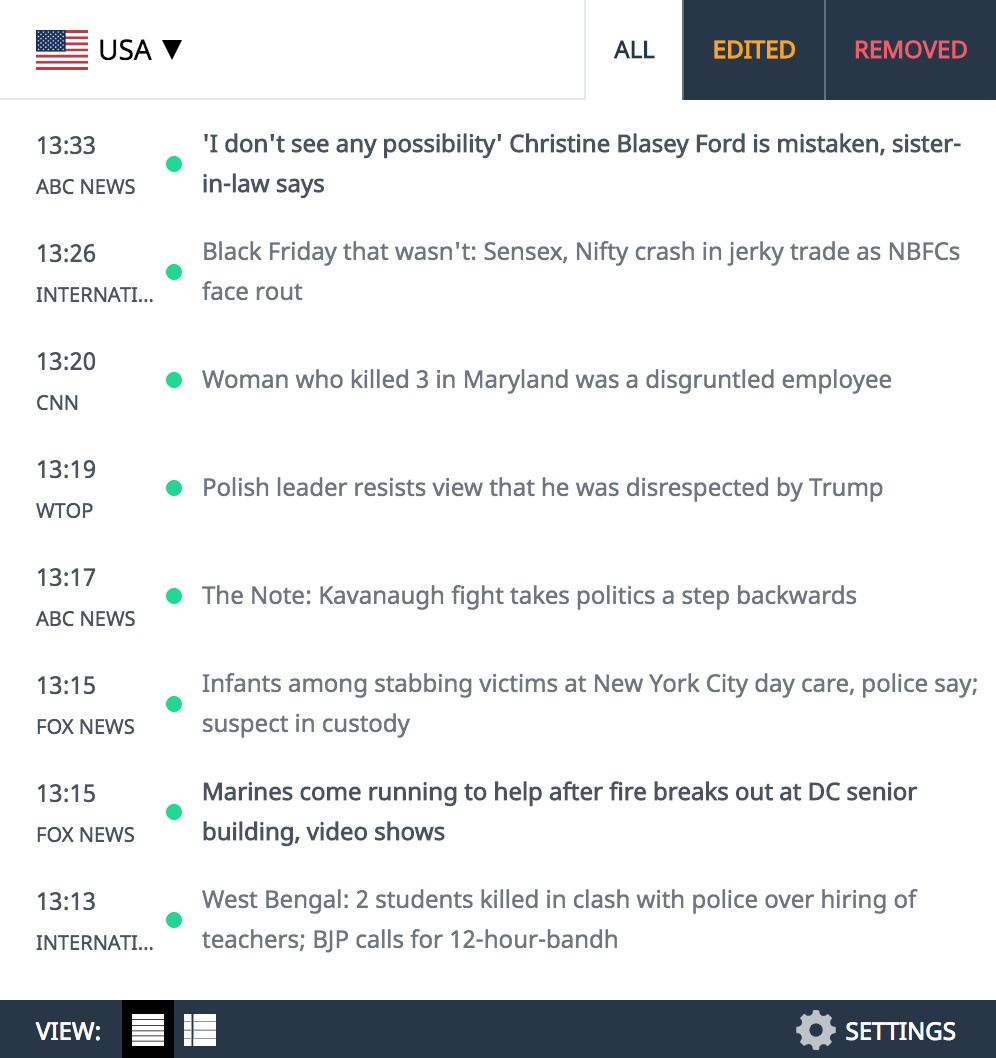

Gefragt nach «Pinnochio» fertigte die Künstliche Intelligenz «Dall-E» diese Illustration an.

Illustration: Dall-E/TA

Wie ein «altkluges Kind» klinge die Sprach-KI Chat-GPT manchmal, meint Aljoscha Burchardt vom Zentrum für künstliche Intelligenz in Berlin. In einem souveränen und überzeugenden Ton antwortet es auf Fragen – nur oft stimmen die behaupteten Fakten nicht. Auch dort täuscht Chat-GPT, wo man es mit am wenigsten toleriert – in der Wissenschaft:

Frage: «Welches ist die meistzitierte wirtschaftswissenschaftliche Arbeit aller Zeiten?»

Chat-GPT im Test

Antwort: «A Theory of Economic History»

Den Test machte der twitternde australische Ökonom David Smerdon mit der Software der kalifornischen Firma Open AI. Der Artikel «A Theory of Economic History» (Theorie der Wirtschaftsgeschichte) von Douglass North und Robert Thomas, publiziert 1969 im «Journal of Economic History», sei 30’000 Mal zitiert worden, so die Künstliche Intelligenz. Doch die beiden einflussreichen Ökonomen haben nie einen Artikel dieses Titels verfasst. Chat-GPT hat die Referenz erfunden. KI-Fachleute nennen eine solche Melange aus Fakten und Fiktion «Halluzination». Sprachmodelle, wie man derlei eloquente Algorithmen auch nennt, halluzinieren häufig. Das ist auch bei GPT-4 nicht prinzipiell anders, dem jüngst vorgestellten neuesten Sprachmodell aus der Chat-GPT-Schmiede Open AI. Die erzeugten Texte enthalten keine Hinweise, was Fakt ist und was Fiktion.

Sprachmodelle raten

«Chat-GPT ist keine Faktensuchmaschine», erklärt Burchardt. Es sei darauf trainiert, plausibel klingende Texte zu verfassen, «mehr nicht», sagt der Computerlinguist. Chat-GPT kenne das Konzept der Wahrheit nicht, ergänzt Jonas Andrulis, Chef der Heidelberger Firma Aleph Alpha, die ebenfalls ein Sprachmodell entwickelt hat. Dass Sprachmodelle halluzinieren, steckt in ihrer Funktionsweise. Die Algorithmen ahmen die Vernetzung zwischen Neuronen im menschlichen Hirn nach. Dank immer billigerer Rechenkraft wurden diese künstlichen neuronalen Netze immer grösser. Sie können mit immer mehr Daten trainieren und subtile Muster darin erkennen. Das geht auch mit Sprache. Das Sprachmodell, auf dem Chat-GPT basiert, wurde mit Texten von Milliarden Websites und Millionen Büchern trainiert. Es erlernte dabei aber kein konsistentes Weltwissen. Sprachmodelle fertigen nur ein statistisches Modell über Wortfolgen an. Bei einem gegebenen Textanfang können sie berechnen, welches Wort am wahrscheinlichsten als Nächstes folgt. So entsteht Wort für Wort Wie faktentreu der ist, hängt davon ab, wie häufig eine Wortfolge in den Trainingstexten vorkam. Manches, was Chat-GPT schreibt, stimmt, weil es Menschen schon oft geschrieben haben. Auf «Urlaub in Sri ...» lässt sich schwerlich etwas anderes ergänzen als «Lanka». Unsicherer ist hingegen die Fortsetzung des folgenden Satzanfangs: «Bei den Landtagswahlen in Hessen erhielt die ...». Es könnte genauso gut mit «CDU» wie mit «SPD» weitergehen. Chat-GPT zeichnet sich dadurch aus, dass es beim Raten des nächsten Worts besonders viel vorausgehenden Text berücksichtigt. Das lässt seine Texte in sich stimmig und menschlich wirken. Wenn in den etwa 1500 Wörtern davor die SPD schon vorgekommen ist, steigt die Wahrscheinlichkeit, dass das nächste Wort «CDU» lautet. Das ändert aber nichts daran, dass Sprachmodelle im Kern nur raten; der Wahrheitsgehalt wird nicht bewertet.

«Sprachmodelle füllen ihre Wissenslücken mit Fiktion.»

Chunting Zhou, Facebooks KI-Forschungsabteilung Seattle

Ganz allein ist Chat-GPT aber wohl nicht mit seiner Neigung zum Erfinden. Auch Menschen «halluzinieren», wenn sie Texte verfassen, sagt Chunting Zhou aus Facebooks KI-Forschungsabteilung in Seattle. «Wenn menschliche Schreiber auf eine Frage antworten, dann lassen sie oft Hintergrundwissen einfliessen, nach dem gar nicht gefragt worden war», sagt die Informatikerin, die zu Halluzinationen von Sprachmodellen promoviert hat. «Bei ihrem Training mit menschlichen Texten erlernen Sprachmodelle die menschliche Neigung, über den gegebenen Kontext hinauszugehen, und das führt zu Halluzinationen.» Die Forscherin sieht noch einen weiteren Mechanismus am Werk: Sprachmodelle seien nicht darauf trainiert, mit dem aktuellen Weltwissen Schritt zu halten. Ihre Wissenslücken füllen sie mit Fiktion. Aljoscha Burchardt warnt indessen vor anschaulichen Erklärungsversuchen für Chat-GPTs Eingebungen. Für die KI seien Sätze lediglich «Zeichenketten», in denen sie Muster erkennt. So kann man auch nur erahnen, wie und warum Chat-GPT etwa eine wirtschaftswissenschaftliche Arbeit erfindet, wie es David Smerdon auf Twitter vortrug: Theory, Economic und History sind Wörter, die häufig in einschlägigen Titeln vorkommen, der 2015 gestorbene Nobelpreisträger Douglass North ist ein wahrscheinlicher Autor, der wegen einer bekannten gemeinsamen Publikation öfter zusammen mit Robert Thomas erwähnt wird und wegen einer anderen Arbeit auch zusammen mit dem «Journal of Economic History», sodass hier jedes Puzzleteil plausibel zu einem anderen passt. Nur leider nicht alle zusammen, aber das kann Chat-GPT eben nicht wissen.

Gegen Halluzination wehren

Dass Sprachmodelle sich nicht so leicht in die Karten schauen lassen, macht es schwer, technische Lösungen gegen die Halluzinationen zu finden. Chunting Zhou schlägt vor, Sprachmodelle mit Suchmaschinen zu koppeln. Diese könnten in der Datenbasis nachsehen, ob das Geschriebene stimmt, und Textstellen markieren, die womöglich nur halluziniert sind. Die beim Factchecking gefundenen Quellen könnten sie als Link an den vom Sprachmodell erzeugten Text anhängen. Für sein Sprachmodell Luminous hat Aleph Alpha eine ähnliche Technik entwickelt. Die Software sucht in einem Datenpool nach Quellen, auf denen die Antwort der KI beruht. «Diese wird als Link der Antwort hinzugefügt», erklärt Jonas Andrulis. Allerdings soll Luminous nicht als Chatbot für alles eingesetzt werden wie Chat-GPT, sondern in abgegrenzten Anwendungen. Der Datenpool, oder die Wissensbasis, wie Andrulis es nennt, beschränkt sich auf das jeweilige Feld. Mit der Stadt Heidelberg zum Beispiel entwickelt das Unternehmen derzeit den virtuellen Bürgerassistenten «Lumi», der den Heidelbergern Fragen beantworten soll, etwa wie man einen Wohnsitz anmeldet oder was der Gemeinderat zuletzt entschieden hat. Die Wissensbasis für das Factchecking stellt die Stadt bereit. «Wenn Lumi keinen Beweis findet, soll es schreiben, dass es nicht antworten kann», sagt Andrulis. Eines werden die Sprachmodelle dadurch aber nicht lernen. «Menschen haben Werte», sagt Andrulis. «Dazu gehört, dass man keine falschen Aussagen macht.» Allerdings: Bei den spektakulären Sprüngen, die die Technik in den vergangenen Monaten machte, würde es kaum verwundern, wenn eine KI dann doch bald so etwas wie ein schlechtes Gewissen hätte, wenn sie lügt.

Fehler gefunden? Jetzt melden.